Pergunte agora

Mercado de inferência da IA

Tamanho do mercado de inferência de IA, compartilhamento, crescimento e análise da indústria, por computação (GPU, CPU, FPGA, NPU, outros), por memória (DDR, HBM), por implantação (nuvem, local, borda), por aplicação, por usuário final e análise regional, Análise Regional, 2025-2032

Páginas: 200 | Ano base: 2024 | Lançamento: July 2025 | Autor: Versha V.

Ai Inferência do mercado instantâneo

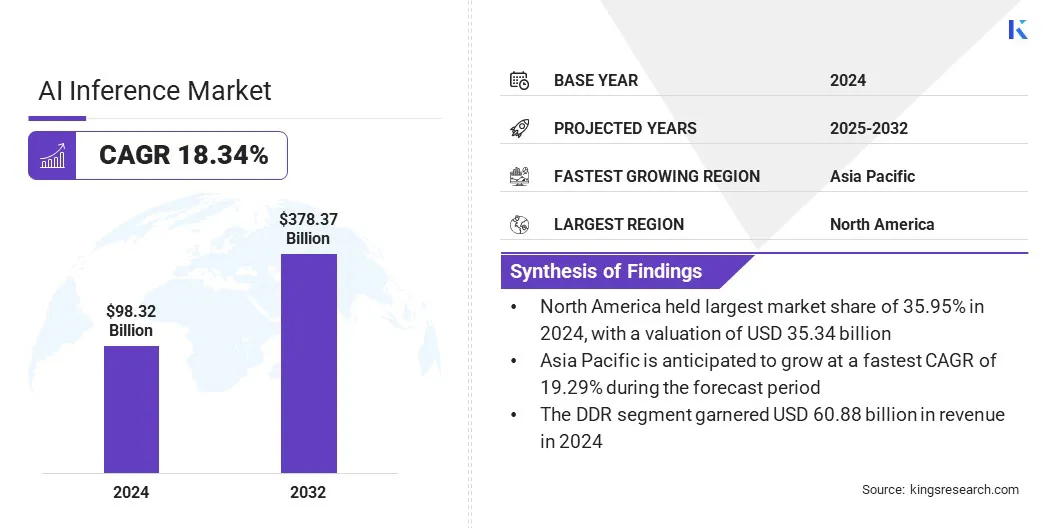

O tamanho do mercado global de inferência de IA foi avaliado em US $ 98,32 bilhões em 2024 e deve crescer de US $ 116,30 bilhões em 2025 para US $ 378,37 bilhões em 2032, exibindo um CAGR de 18,34% durante o período de previsão. O mercado está experimentando um crescimento robusto, impulsionado principalmente pela rápida proliferação de aplicações generativas de IA em diversas indústrias.

À medida que as empresas implantam cada vez mais modelos de IA para tarefas como geração de conteúdo, tradução em tempo real e recomendações personalizadas, aumentou a demanda por soluções de inferência eficientes e de alto desempenho.

Principais destaques do mercado:

- O tamanho do mercado global foi avaliado em US $ 98,32 bilhões em 2024.

- O mercado deve crescer a uma CAGR de 18,34% de 2025 a 2032.

- A América do Norte detinha uma ação de 35,95% em 2024, avaliada em US $ 35,34 bilhões.

- O segmento GPU recebeu 27,61 bilhões de dólares em receita em 2024.

- O segmento DDR deve atingir US $ 228,57 bilhões até 2032.

- O segmento em nuvem deve gerar uma receita de US $ 151,53 bilhões até 2032.

- O segmento generativo de IA deve atingir US $ 136,69 bilhões até 2032.

- Estima -se que o segmento de empresas atinja US $ 164,68 bilhões até 2032.

- Prevê -se que a Ásia -Pacífico cresça em uma CAGR robusta de 19,29% durante o período de previsão.

Major companies operating in the AI inference industry are OpenAI, Amazon.com, Inc., Alphabet Inc, IBM, Hugging Face, Inc., Baseten, Together Computer Inc, Deep Infra, Modal, NVIDIA Corporation, Advanced Micro Devices, Inc., Intel Corporation, Cerebras, Huawei Investment & Holding Co., Ltd., and d-Matrix, Inc.

Visão geral do mercado de inferência de IA

A ênfase crescente na soberania de dados e na conformidade regulatória está influenciando a demanda corporativa por soluções de inferência de IA. As organizações preferem cada vez mais serviços de inferência que oferecem desempenho em tempo real com controle completo sobre dados e infraestrutura.

- Em junho de 2025, a GCORE e a Orange Business lançaram um programa de co-innovação estratégico para fornecer um serviço de inferência de IA soberana e de grau de produção. A solução combina o serviço de implantação privada de inferência de IA da GCore com a infraestrutura de nuvem confiável da Orange Business, permitindo que as empresas implantem cargas de trabalho de inferência em tempo real em tempo real em escala em toda a Europa, com foco no desempenho de baixa latência, conformidade regulatória e simplicidade operacional.

Piloto de mercado

Proliferação de aplicações generativas de IA

O mercado está experimentando um rápido crescimento, impulsionado pela proliferação de aplicações generativas de IA. À medida que as organizações implantam cada vez mais modelos de idiomas grandes, ferramentas de design generativas, assistentes virtuais e plataformas de criação de conteúdo, a necessidade de recursos de inferência rápida, precisa e escalável se intensificaram.

Esses aplicativos generativos exigem desempenho de alto rendimento para processar conjuntos de dados vastos e complexos, enquanto fornecem saídas contextualmente relevantes em tempo real. Para atender a esses requisitos, as empresas estão adotando hardware de inferência avançada, otimizando pilhas de software e utilizando infraestrutura nativa em nuvem que suporta escala dinâmica.

Esse aumento no uso generativo de IA em setores como saúde, finanças, educação e entretenimento está transformando os fluxos de trabalho digitais e acelerando a demanda por soluções de inferência de alto desempenho.

- Em abril de 2025, o Google introduziu a Ironwood, sua TPU de sétima geração, projetada especificamente para inferência. A Ironwood suporta cargas de trabalho de IA generativas em larga escala com potência, memória e eficiência energética aprimorada de computação. Ele integra o software Pathways do Google e apresenta uma largura de banda SparSecore e ICI aprimorada, permitindo a inferência de alto desempenho e escalável por modelos avançados de IA em vários setores.

Desafio de mercado

Desafios de escalabilidade e infraestrutura na inferência de IA

Um grande desafio que impede o progresso do mercado de inferência de IA é alcançar escalabilidade e gerenciar a complexidade da infraestrutura. À medida que as organizações adotam cada vez mais os modelos de IA para a tomada de decisões em tempo real e de alto volume, a manutenção do desempenho consistente em ambientes distribuídos se torna difícil.

Escalar os sistemas de inferência para atender à demanda flutuante sem os recursos sobreviventes ou comprometimento da latência é uma preocupação persistente. Além disso, a complexidade da implantação, gerenciamento e otimização de diversas pilhas de hardware e software em ambientes híbridos e de várias nuvens adiciona tensão operacional.

Para enfrentar esses desafios, as empresas estão investindo em soluções dinâmicas de infraestrutura, incluindo arquiteturas sem servidor, plataformas de inferência distribuídas e ferramentas automatizadas de orquestração de recursos.

Essas inovações permitem que as empresas escalarem cargas de trabalho de inferência com eficiência, simplificando o gerenciamento de infraestrutura, apoiando assim a adoção mais ampla de IA em vários setores.

- Em dezembro de 2024, a Amazon introduziu um novo recurso "escala para zero" para os pontos de extremidade de inferência de sagemaker. Esse recurso permite que os terminais escalem automaticamente para zero instâncias durante a inatividade, otimizando o gerenciamento de recursos e a eficiência de custos para operações de inferência de AI baseadas em nuvem.

Tendência de mercado

Permitir inteligência em tempo real com inferência de nuvem híbrida

O mercado está testemunhando uma tendência crescente em direção a soluções de inferência baseadas em nuvem híbridas, apoiadas pela crescente demanda por escalabilidade, flexibilidade e desempenho de baixa latência.

À medida que as empresas implantam modelos de IA em diversas geografias e casos de uso, arquiteturas híbridas que integrem nuvem pública, nuvem privada e computação de borda facilitam a distribuição dinâmica das cargas de trabalho de inferência.

- Por exemplo, em junho de 2025, a Akamai introduziu sua plataforma de inferência de IA integrada ao Spinkube e WebAssembly para ativar a implantação do modelo de baixa latência na borda. Em execução em uma infraestrutura em nuvem distribuída globalmente, a plataforma suporta modelos de IA leves e específicos de domínio para aplicativos em tempo real, refletindo uma mudança do treinamento centralizado para a inferência de IA distribuída em ambientes híbridos de ponta de nuvem.

Essa abordagem permite o processamento de dados mais próximo da fonte, melhorando os tempos de resposta, garantindo a conformidade regulatória e otimizando o custo, distribuindo cargas de trabalho entre nós centralizados e de borda. A inferência híbrida em nuvem é cada vez mais vital para apoiar aplicativos de IA em tempo real e avançar a inovação.

Relatório do mercado de inferência da IA instantâneo

|

Segmentação |

Detalhes |

|

Por computação |

GPU, CPU, FPGA, NPU, outros |

|

Por memória |

DDR, HBM |

|

Por implantação |

Cloud, no local, Edge |

|

Por aplicação |

IA generativa, aprendizado de máquina, processamento de linguagem natural, visão computacional |

|

Pelo usuário final |

Consumidor, provedores de serviços em nuvem, empresas |

|

Por região |

América do Norte: EUA, Canadá, México |

|

Europa: França, Reino Unido, Espanha, Alemanha, Itália, Rússia, Resto da Europa | |

|

Ásia-Pacífico: China, Japão, Índia, Austrália, ASEAN, Coréia do Sul, Resto da Ásia-Pacífico | |

|

Oriente Médio e África: Turquia, U.A.E., Arábia Saudita, África do Sul, Resto do Oriente Médio e África | |

|

Ámérica do Sul: Brasil, Argentina, Resto da América do Sul |

Segmentação de mercado

- Por computação (GPU, CPU, FPGA, NPU e outros): o segmento GPU ganhou US $ 27,61 bilhões em 2024, principalmente devido aos seus recursos superiores de processamento paralelo, tornando-o ideal para cargas de trabalho de IA de alto desempenho.

- Por memória (DDR e HBM): o segmento DDR detinha uma participação de 61,92%em 2024, alimentada por sua compatibilidade e custo-efetividade generalizada para tarefas gerais de inferência de IA.

- Por implantação (nuvem, local e borda): o segmento de nuvem deve atingir US $ 151,53 bilhões até 2032, devido à sua escalabilidade, flexibilidade e acesso à infraestrutura de IA robusta.

- Por aplicação (IA generativa,Aprendizado de máquina, Processamento de linguagem natural e visão computacional): O segmento generativo de IA deve atingir US $ 136,69 bilhões até 2032, devido à crescente adoção nas aplicações de criação, codificação e design de conteúdo.

- Por usuário final (consumidor, provedores de serviços em nuvem e empresas): o segmento de empresas deve atingir US $ 164,68 bilhões até 2032, impulsionado pela crescente integração da IA em operações comerciais, análises e estratégias de automação.

Análise regional do mercado de inferência de IA

Com base na região, o mercado foi classificado na América do Norte, Europa, Ásia -Pacífico, Oriente Médio e África e América do Sul.

O mercado de inferência da AI da América do Norte representou uma participação substancial de 35,95% em 2024, avaliada em US $ 35,34 bilhões. Esse domínio é reforçado pela crescente adoção de inferência de arestas em setores como automotivo, dispositivos inteligentes e automação industrial, onde a latência ultra baixa e o processamento localizado estão se tornando requisitos operacionais.

A crescente disponibilidade de plataformas de AI-A-A-A-Service também está reformulando os modelos de implantação corporativa da IA, oferecendo inferência escalável sem infraestrutura dedicada.

- Por exemplo, em dezembro de 2024, a Amazon Web Services (AWS) investiu US $ 10 bilhões para expandir sua infraestrutura de nuvem e IA. O investimento visa estabelecer novos data centers para atender à crescente demanda, além de apoiar o avanço tecnológico e fortalecer o papel de Ohio na economia digital.

Esse desenvolvimento fortalece o ecossistema de inferência da IA, expandindo os recursos de IA baseados em nuvem na região. À medida que as empresas dependem cada vez mais de infraestrutura de nuvem robustas para implantar modelos de inferência em escala, espera -se que esses investimentos acelerem a inovação e a adoção entre os setores, reforçando a posição de liderança da América do Norte.

O setor de inferência de IA da Ásia-Pacífico deverá registrar o CAGR mais rápido de 19,29% durante o período de previsão. Esse crescimento é atribuído principalmente à crescente adoção de tecnologias movidas a IA entre os principais verticais, incluindo fabricação, telecomunicações e assistência médica.

A crescente demanda por tomada de decisão em tempo real e de baixa latência está aumentando a implantação de soluções de inferência de AI Edge, particularmente nos ecossistemas de fabricação inteligentes e aplicativos de robótica. Além disso, os programas de digitalização contínuos liderados pelo governo e os esforços estratégicos para fortalecer os recursos domésticos de IA estão promovendo um ambiente propício para a implantação escalável da IA.

- Em junho de 2025, o SK Group e a Amazon Web Services entraram em uma parceria estratégica de 15 anos para construir um data center de IA em Ulsan, na Coréia do Sul. A colaboração pretende estabelecer uma nova zona da AWS AI, com infraestrutura de IA dedicada, redes ultracluster e serviços como a Amazon Sagemaker e a Amazon Bedrock para apoiar o desenvolvimento de aplicativos avançados de IA localmente.

Estruturas regulatórias

- Nos EUA, a Comissão Federal de Comércio (FTC) e a Food and Drug Administration (FDA) regulaminteligência artificial, com a FTC supervisionando seu uso na proteção do consumidor e o FDA que governa sua aplicação em dispositivos médicos.

Cenário competitivo

O mercado de inferência de IA é caracterizado por avanços contínuos na otimização do motor e uma crescente mudança para infraestrutura modular de código aberto.

As empresas estão priorizando o refinamento dos mecanismos de inferência para permitir tempos de resposta mais rápidos, menor latência e redução do consumo de energia. Esses aprimoramentos são críticos para escalar aplicativos de IA em tempo real em ambientes em nuvem, borda e híbrido.

O setor está testemunhando a crescente adoção de estruturas de código aberto e arquiteturas modulares de sistemas que permitem implantações flexíveis e agnósticas de hardware. Essa abordagem capacita os desenvolvedores a integrar soluções de inferência personalizadas, adaptadas a cargas de trabalho específicas, otimizando a utilização e a eficiência dos recursos.

Esses avanços estão permitindo maior escalabilidade, interoperabilidade e eficiência operacional na entrega dos recursos da AI da Grade Enterprise.

- Em junho de 2025, a Oracle e a NVIDIA expandiram sua colaboração para aprimorar os recursos de treinamento e inferência de IA, tornando a empresa NVIDIA AI disponível nativamente no Oracle Cloud Infrastructure Console. Essa integração permite que os clientes acessem mais de 160 ferramentas de IA, incluindo microsserviços de inferência otimizados, e alavancam os sistemas NVIDIA GB200 NVL72 para implantações de IA de alto desempenho, escalável e econômico em ambientes de nuvem distribuídos.

- Em maio de 2025, a Red Hat apresentou o Red Hat Ai Inference Server, construído no projeto VLLM de código aberto e aprimorado com tecnologias de mágica neural. A plataforma foi projetada para fornecer inferência de IA de alto desempenho e custo-econômico em ambientes em nuvem híbridos, suportando modelos generativos de IA em qualquer acelerador.

Principais empresas no mercado de inferência de IA:

- Openai

- com, Inc.

- Alphabet inc

- IBM

- Abraçando o rosto, Inc.

- BASETEN

- Juntos Computer Inc.

- Infra profundo

- Modal

- Nvidia Corporation

- Advanced Micro Devices, Inc.

- Intel Corporation

- Cerebras

- Huawei Investment & Holding Co., Ltd.

- D-Matrix, Inc.

Desenvolvimentos recentes (parcerias/lançamentos de produtos)

- Em maio de 2025, Ooda AI fez uma parceria com a Phala Network para explorar a integração da inferência confidencial da IA usando ambientes de execução confiável e infraestrutura descentralizada de GPU. A colaboração concentra-se na construção de uma rede de inferência de AI verificável e preservadora de privacidade, alavancando provas de zero e conhecimento e tecnologias de computação confidencial baseadas em blockchain.

- Em janeiro de 2025A Qualcomm Technologies, Inc. lançou a Solução de Appliance On-Prem e a IA Inference. As ofertas permitem a implantação local de IA generativa e cargas de trabalho de visão computacional, permitindo que as empresas mantenham a privacidade de dados, reduzam os custos operacionais e implantam aplicativos de IA localmente entre os setores com apoio de Honeywell, Aetina e IBM.

- Em janeiro de 2025A Novita AI fez uma parceria com a VLLM para aprimorar os recursos de inferência de IA para grandes modelos de idiomas. A colaboração permite que os desenvolvedores implantem LLMs de código aberto, como o LLAMA 3.1, usando o algoritmo de Pagedattion da VLLM na infraestrutura em nuvem GPU da Novita AI, melhorando o desempenho, reduzindo os custos e avançando o desenvolvimento de IA de código aberto.

- Em agosto de 2024, A Cerebras Systems lançou a inferência de cerebras, uma solução de inferência de IA capaz de fornecer até 1.800 tokens por segundo. Alimentado pelo mecanismo de escala de wafer 3, a solução oferece custos significativamente mais baixos e desempenho mais alto que as alternativas baseadas em GPU, com camadas de preços gratuitos, desenvolvedores e corporativos.

Perguntas frequentes