Pregunte ahora

Mercado de inferencias de IA

Tamaño del mercado de inferencia de IA, participación, crecimiento e análisis de la industria, por cómputo (GPU, CPU, FPGA, NPU, otros), por memoria (DDR, HBM), por implementación (Cloud, Injate, Edge), por aplicación, por usuario final y análisis regional, 2025-2032

Páginas: 200 | Año base: 2024 | Lanzamiento: July 2025 | Autor: Versha V.

Instantánea del mercado de inferencias de IA

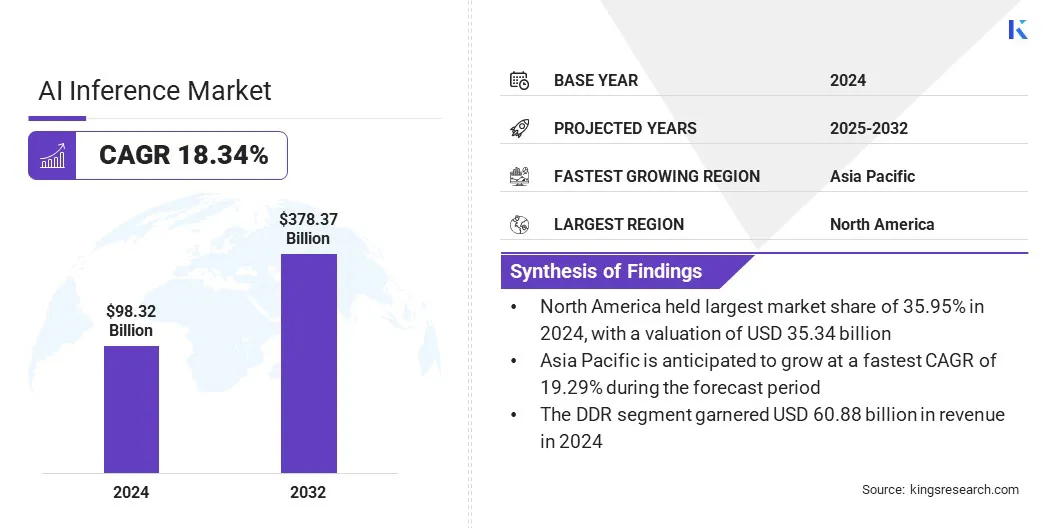

El tamaño del mercado global de inferencias de IA se valoró en USD 98.32 mil millones en 2024 y se prevé que crecerá de USD 116.30 mil millones en 2025 a USD 378.37 mil millones para 2032, exhibiendo una tasa compuesta anual de 18.34% durante el período de pronóstico. El mercado está experimentando un crecimiento robusto, impulsado principalmente por la rápida proliferación de aplicaciones generativas de IA en diversas industrias.

A medida que las empresas implementan cada vez más modelos de IA para tareas como la generación de contenido, la traducción en tiempo real y las recomendaciones personalizadas, la demanda de soluciones eficientes de inferencia de alto rendimiento ha aumentado.

Destacados del mercado clave:

- El tamaño del mercado global se valoró en USD 98.32 mil millones en 2024.

- Se proyecta que el mercado crecerá a una tasa compuesta anual de 18.34% de 2025 a 2032.

- América del Norte mantuvo una participación del 35,95% en 2024, valorada en USD 35,34 mil millones.

- El segmento de GPU obtuvo USD 27.61 mil millones en ingresos en 2024.

- Se espera que el segmento DDR alcance los USD 228.57 mil millones para 2032.

- Se proyecta que el segmento en la nube genere un ingreso de USD 151.53 mil millones para 2032.

- Se espera que el segmento de IA generativo alcance los USD 136.69 mil millones para 2032.

- Se estima que el segmento de las empresas alcanza USD 164.68 mil millones para 2032.

- Se anticipa que Asia Pacífico crece a una tasa compuesta anual de 19.29% durante el período de pronóstico.

Las principales empresas que operan en la industria de inferencias de IA son OpenAI, Amazon.com, Inc., Alphabet Inc, IBM, Hugging Face, Inc., Baseten, Together Computer Inc, Deep Infra, Modal, Nvidia Corporation, Advanced Micro Devices, Inc., Intel Corporation, Cerebras, Huawei Investment & Holding Co., Ltd., y D-Matrix, Inc.

Descripción general del mercado de IA Inferencias

El creciente énfasis en la soberanía de los datos y el cumplimiento regulatorio está influyendo en la demanda empresarial de soluciones de inferencia de IA. Las organizaciones prefieren cada vez más servicios de inferencia que brindan un rendimiento en tiempo real con control completo sobre datos e infraestructura.

- En junio de 2025, Gcore y Orange Business lanzaron un programa de coinnovación estratégica para ofrecer un servicio soberano de inferencia de IA de nivel de producción. La solución combina el servicio de implementación privada de inferencia de IA de AI de GCORE con la infraestructura en la nube de confianza de Orange Business, que permite a las empresas implementar cargas de trabajo de inferencia en tiempo real y compatibles a escala en toda Europa, con un enfoque en el rendimiento de baja latencia, el cumplimiento regulatorio y la simplicidad operacional.

Conductor de mercado

Proliferación de aplicaciones generativas de IA

El mercado está experimentando un rápido crecimiento, impulsado por la proliferación de aplicaciones generativas de IA. A medida que las organizaciones implementan cada vez más modelos de idiomas grandes, las herramientas de diseño generativas, los asistentes virtuales y las plataformas de creación de contenido, la necesidad de capacidades de inferencia rápidas, precisas y escalables se ha intensificado.

Estas aplicaciones generativas exigen un rendimiento de alto rendimiento para procesar conjuntos de datos vastos y complejos al tiempo que entregan resultados en tiempo real y contextualmente relevantes. Para abordar estos requisitos, las empresas están adoptando hardware de inferencia avanzada, optimizando las pilas de software y utilizando infraestructura nativa de la nube que admite la escala dinámica.

Este aumento en el uso generativo de IA en sectores como la atención médica, las finanzas, la educación y el entretenimiento está transformando los flujos de trabajo digitales y acelerando la demanda de soluciones de inferencia de alto rendimiento.

- En abril de 2025, Google introdujo Ironwood, su TPU de séptima generación, diseñada específicamente para la inferencia. Ironwood admite cargas de trabajo generativas de IA generativas a gran escala con potencia de cómputo, memoria y eficiencia energética mejorada. Integra el software Pathways de Google y presenta un mayor ancho de banda de Sparsecore y ICI, lo que permite una inferencia de alto rendimiento e escalable para modelos AI avanzados en varias industrias.

Desafío del mercado

Desafíos de escalabilidad e infraestructura en la inferencia de IA

Un desafío importante que impide el progreso del mercado de inferencias de IA es lograr la escalabilidad y la gestión de la complejidad de la infraestructura. A medida que las organizaciones adoptan cada vez más modelos de IA para la toma de decisiones en tiempo real y de alto volumen, mantener un rendimiento constante en entornos distribuidos se vuelve difícil.

La escala de sistemas de inferencia para satisfacer la demanda fluctuante sin recursos sobreprovisionados o la latencia comprometida es una preocupación persistente. Además, la complejidad de implementar, administrar y optimizar diversas pilas de hardware y software en entornos híbridos y de múltiples nubes agrega tensión operativa.

Para abordar estos desafíos, las empresas están invirtiendo en soluciones de infraestructura dinámica, incluidas arquitecturas sin servidor, plataformas de inferencia distribuidas y herramientas automatizadas de orquestación de recursos.

Estas innovaciones permiten a las empresas a escala las cargas de trabajo de inferencia de escala de manera eficiente al tiempo que simplifican la gestión de la infraestructura, lo que respalda la adopción de IA más amplia en varias industrias.

- En diciembre de 2024, Amazon introdujo una nueva función "Escala hasta cero" para los puntos finales de inferencia de Sagemaker. Esta característica permite que los puntos finales se escalaran automáticamente a cero instancias durante la inactividad, optimizando la gestión de recursos y la eficiencia de rentabilidad para las operaciones de inferencia de IA basadas en la nube.

Tendencia de mercado

Habilitar la inteligencia en tiempo real con inferencia de nubes híbridas

El mercado está presenciando una tendencia creciente hacia las soluciones de inferencia híbridas basadas en la nube, respaldadas por la creciente demanda de escalabilidad, flexibilidad y rendimiento de baja latencia.

A medida que las empresas implementan modelos de IA en diversas geografías y casos de uso, las arquitecturas híbridas que integran la nube pública, la nube privada y la computación de borde facilitan la distribución dinámica de las cargas de trabajo de inferencia.

- Por ejemplo, en junio de 2025, Akamai introdujo su plataforma de inferencia de IA integrada con Spinkube y WebAssembly para permitir la implementación del modelo de baja latencia en el borde. Al ejecutar una infraestructura en la nube distribuida a nivel mundial, la plataforma admite modelos IA livianos y específicos de dominio para aplicaciones en tiempo real, lo que refleja un cambio de capacitación centralizada a inferencia de IA distribuida en entornos híbridos de borde de la nube.

Este enfoque permite el procesamiento de datos más cerca de la fuente, mejorando los tiempos de respuesta, garantizar el cumplimiento regulatorio y la optimización del costo distribuyendo cargas de trabajo entre nodos centralizados y de borde. La inferencia de nubes híbridas es cada vez más vital para apoyar aplicaciones de IA en tiempo real y avanzar en la innovación.

Informe de mercado de inferencia de IA Instantánea

|

Segmentación |

Detalles |

|

Por cómputo |

GPU, CPU, FPGA, NPU, otros |

|

Por memoria |

DDR, HBM |

|

Por despliegue |

Nube, en las instalaciones, borde |

|

Por aplicación |

IA generativa, aprendizaje automático, procesamiento del lenguaje natural, visión por computadora |

|

Por usuario final |

Consumidor, proveedores de servicios en la nube, empresas |

|

Por región |

América del norte: Estados Unidos, Canadá, México |

|

Europa: Francia, Reino Unido, España, Alemania, Italia, Rusia, resto de Europa | |

|

Asia-Pacífico: China, Japón, India, Australia, ASEAN, Corea del Sur, resto de Asia-Pacífico | |

|

Medio Oriente y África: Turquía, U.A.E., Arabia Saudita, Sudáfrica, resto del Medio Oriente y África | |

|

Sudamerica: Brasil, Argentina, resto de América del Sur |

Segmentación de mercado

- Por cómputo (GPU, CPU, FPGA, NPU y otros): el segmento de GPU ganó USD 27.61 mil millones en 2024, principalmente debido a sus capacidades de procesamiento paralelas superiores, lo que lo hace ideal para cargas de trabajo de IA de alto rendimiento.

- Por memoria (DDR y HBM): el segmento DDR tenía una participación de 61.92%en 2024, alimentada por su compatibilidad generalizada y rentabilidad para las tareas de inferencia de IA general.

- Por implementación (Cloud, In-Mises y Edge): se proyecta que el segmento de la nube alcance los USD 151.53 mil millones para 2032, debido a su escalabilidad, flexibilidad y acceso a una infraestructura de IA robusta.

- Por aplicación (AI generativo,Aprendizaje automático, Procesamiento del lenguaje natural y visión por computadora): se proyecta que el segmento de IA generativo alcance los USD 136.69 mil millones para 2032, debido al aumento de la adopción de la creación de contenido, la codificación y las aplicaciones de diseño.

- Por usuario final (consumidor, proveedores de servicios en la nube y empresas): se proyecta que el segmento de empresas alcance USD 164.68 mil millones para 2032, impulsado por la creciente integración de IA en operaciones comerciales, análisis y estrategias de automatización.

Análisis regional del mercado de inferencias de IA

Basado en la región, el mercado se ha clasificado en América del Norte, Europa, Asia Pacífico, Medio Oriente y África y América del Sur.

El mercado de inferencias de IA de América del Norte representó una participación sustancial de 35.95% en 2024, valorada en USD 35.34 mil millones. Este dominio se ve reforzado por la creciente adopción de la inferencia de IA Edge en sectores como automotriz, dispositivos inteligentes y automatización industrial, donde la latencia ultra baja y el procesamiento localizado se están convirtiendo en requisitos operativos.

La creciente disponibilidad de plataformas AI-as-a-Service también está reestructurando modelos de implementación de IA empresarial al ofrecer una inferencia escalable sin infraestructura dedicada.

- Por ejemplo, en diciembre de 2024, Amazon Web Services (AWS) invirtió USD 10 mil millones N Ohio para expandir su infraestructura en la nube y la IA. La inversión tiene como objetivo establecer nuevos centros de datos para satisfacer la creciente demanda, al tiempo que apoya el avance tecnológico y el fortalecimiento del papel de Ohio en la economía digital.

Este desarrollo fortalece el ecosistema de inferencia de IA al expandir las capacidades de IA basadas en la nube en la región. A medida que las empresas dependen cada vez más de una infraestructura de nube robusta para desplegar modelos de inferencia a escala, se espera que estas inversiones aceleren la innovación y la adopción entre los sectores, lo que refuerza la posición principal de América del Norte.

Se espera que la industria de inferencia de IA de Asia-Pacífico registre la tasa compuesta anual más rápida del 19.29% durante el período de pronóstico. Este crecimiento se atribuye principalmente a la creciente adopción de tecnologías con IA a través de verticales clave, incluidas la fabricación, las telecomunicaciones y la atención médica.

La creciente demanda de toma de decisiones en tiempo real y de baja latencia está aumentando el despliegue de soluciones de inferencia de IA Edge, particularmente dentro de los ecosistemas de fabricación inteligentes y las aplicaciones de robótica. Además, los continuos programas de digitalización dirigidos por el gobierno y los esfuerzos estratégicos para fortalecer las capacidades de IA nacionales están fomentando un entorno propicio para la implementación de IA escalable.

- En junio de 2025, SK Group y Amazon Web Services ingresaron a una asociación estratégica de 15 años para construir un centro de datos de IA en Ulsan, Corea del Sur. La colaboración tiene como objetivo establecer una nueva zona AWS AI con infraestructura de IA dedicada, redes ultracluster y servicios como Amazon Sagemaker y Amazon Bedrock para apoyar el desarrollo de aplicaciones de IA avanzadas localmente.

Marcos regulatorios

- En los EE. UU., la Comisión Federal de Comercio (FTC) y la Administración de Alimentos y Medicamentos (FDA) regulaninteligencia artificial, con la FTC que supervisa su uso en la protección del consumidor y la FDA que rige su aplicación en dispositivos médicos.

Panorama competitivo

El mercado de inferencias de IA se caracteriza por avances continuos en la optimización del motor y un cambio creciente hacia la infraestructura modular de código abierto.

Las empresas están priorizando el refinamiento de los motores de inferencia para permitir tiempos de respuesta más rápidos, menor latencia y un menor consumo de energía. Estas mejoras son críticas para escalar aplicaciones de IA en tiempo real en entornos de nubes, borde e híbridos.

La industria está presenciando la creciente adopción de marcos de código abierto y arquitecturas de sistemas modulares que permiten implementaciones flexibles de hardware. Este enfoque faculta a los desarrolladores para integrar soluciones de inferencia personalizadas adaptadas a cargas de trabajo específicas al tiempo que optimiza la utilización de recursos y la rentabilidad.

Estos avances están permitiendo una mayor escalabilidad, interoperabilidad y eficiencia operativa en la entrega de capacidades de IA de grado empresarial.

- En junio de 2025, Oracle y Nvidia ampliaron su colaboración para mejorar las capacidades de capacitación e inferencia de IA haciendo que Nvidia AI Enterprise esté disponible de forma nativa a través de la consola de infraestructura de Oracle Cloud. Esta integración permite a los clientes acceder a más de 160 herramientas de IA, incluidos microservicios de inferencia optimizados, y aprovechar los sistemas NVIDIA GB200 NVL72 para implementaciones de IA de alto rendimiento, escalables y rentables en entornos de nubes distribuidos.

- En mayo de 2025, Red Hat introdujo el servidor de inferencia Red Hat AI, construido en el proyecto VLLM de código abierto y mejorado con tecnologías de magia neural. La plataforma está diseñada para ofrecer una inferencia de IA de alto rendimiento y rentable en entornos de nubes híbridos, lo que respalda modelos de IA generativos en cualquier acelerador.

Empresas clave en el mercado de inferencias de IA:

- Opadai

- Com, Inc.

- Alphabet Inc

- IBM

- Abrazando la cara, Inc.

- Base

- Together Computer Inc

- Infra profundo

- Modal

- Nvidia Corporation

- Advanced Micro Devices, Inc.

- Intel Corporation

- Cerebras

- Huawei Investment & Holding Co., Ltd.

- D-Matrix, Inc.

Desarrollos recientes (asociaciones/lanzamientos de productos)

- En mayo de 2025, Ooda AI se asoció con Phala Network para explorar la integración de la inferencia confidencial de IA utilizando entornos de ejecución confiables e infraestructura descentralizada de GPU. La colaboración se centra en construir una red de inferencia de IA verificable que preservan la privacidad, aprovechando las pruebas de conocimiento cero y las tecnologías de computación confidenciales basadas en blockchain.

- En enero de 2025, Qualcomm Technologies, Inc. lanzó la solución AI On-Appliance Solution y AI Inference Suite. Las ofertas permiten el despliegue local de cargas de trabajo generativas de IA y visión por computadora, lo que permite a las empresas mantener la privacidad de los datos, reducir los costos operativos e implementar aplicaciones de IA localmente en todas las industrias con el apoyo de Honeywell, Aetina e IBM.

- En enero de 2025Novita AI se asoció con VLLM para mejorar las capacidades de inferencia de IA para modelos de idiomas grandes. La colaboración permite a los desarrolladores implementar LLM de código abierto, como Llama 3.1, utilizando el algoritmo de Pagedattention de VLLM en la infraestructura de la nube GPU de Novita AI, mejorando el rendimiento, la reducción de los costos y el avance de la AI de código abierto.

- En agosto de 2024Los sistemas de cerebras lanzaron inferencia de cerebras, una solución de inferencia de IA capaz de entregar hasta 1.800 tokens por segundo. Impulsada por Wafer Scale Engine 3, la solución ofrece costos significativamente más bajos y un mayor rendimiento que las alternativas basadas en GPU, con niveles de precios gratuitos, de desarrolladores y empresas.

Preguntas frecuentes