Renseignez-vous maintenant

Marché de l'inférence IA

Taille du marché de l'inférence de l'IA, partage, croissance et analyse de l'industrie, par calcul (GPU, CPU, FPGA, NPU, autres), par mémoire (DDR, HBM), par déploiement (cloud, sur site, bord), par application, par l'utilisateur final et l'analyse régionale, 2025-2032

Pages: 200 | Année de base: 2024 | Version: July 2025 | Auteur: Versha V.

Instantané du marché de l'inférence AI

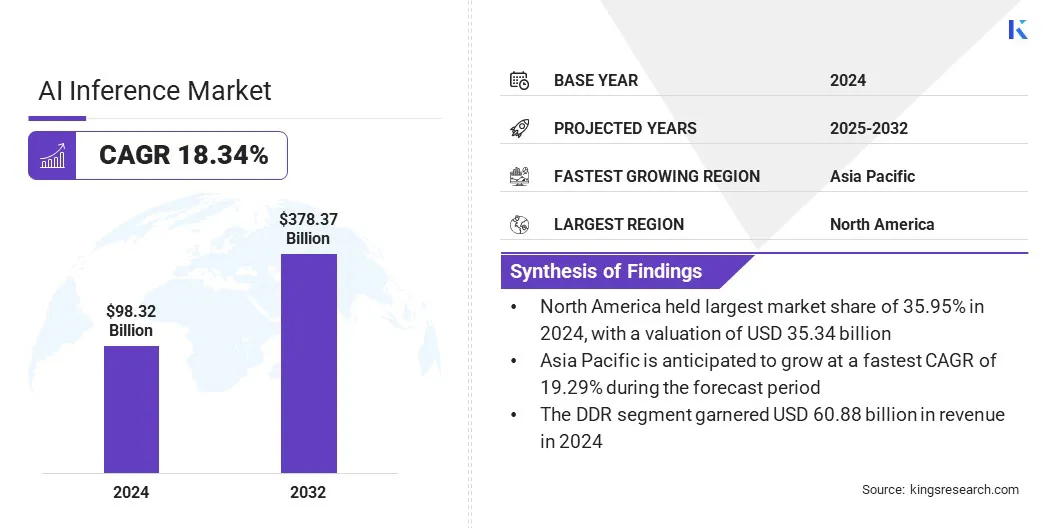

La taille mondiale du marché de l'inférence de l'IA a été évaluée à 98,32 milliards USD en 2024 et devrait passer de 116,30 milliards USD en 2025 à 378,37 milliards USD d'ici 2032, présentant un TCAC de 18,34% au cours de la période de prévision. Le marché connaît une croissance robuste, propulsée principalement par la prolifération rapide des applications génératrices de l'IA dans diverses industries.

Alors que les entreprises déploient de plus en plus des modèles d'IA pour des tâches telles que la génération de contenu, la traduction en temps réel et les recommandations personnalisées, la demande de solutions d'inférence efficaces et hautes performances a augmenté.

Faits saillants du marché clés:

- La taille du marché mondial était évaluée à 98,32 milliards USD en 2024.

- Le marché devrait croître à un TCAC de 18,34% de 2025 à 2032.

- L'Amérique du Nord a détenu une part de 35,95% en 2024, évaluée à 35,34 milliards USD.

- Le segment du GPU a récolté 27,61 milliards de dollars de revenus en 2024.

- Le segment DDR devrait atteindre 228,57 milliards USD d'ici 2032.

- Le segment du cloud devrait générer un chiffre d'affaires de 151,53 milliards USD d'ici 2032.

- Le segment générateur de l'IA devrait atteindre 136,69 milliards USD d'ici 2032.

- Le segment des entreprises devrait atteindre 164,68 milliards USD d'ici 2032.

- L'Asie-Pacifique devrait croître à un TCAC robuste de 19,29% au cours de la période de prévision.

Les grandes entreprises opérant dans l'industrie de l'inférence de l'IA sont Openai, Amazon.com, Inc., Alphabet Inc, IBM, Hugging Face, Inc., Baseten, Together Computer Inc, Deep Infra, Modal, Nvidia Corporation, Advanced Micro Devices, Inc., Intel Corporation, Cerebras, Huawei Investment & Holding Co., Ltd. et D-Matrix, Incc.

Présentation du marché de l'inférence de l'IA

L'accent croissant sur la souveraineté des données et la conformité réglementaire influence la demande d'entreprise de solutions d'inférence de l'IA. Les organisations préfèrent de plus en plus les services d'inférence qui offrent des performances en temps réel avec un contrôle complet sur les données et les infrastructures.

- En juin 2025, GCORE et Orange Business ont lancé un programme de co-innovation stratégique pour offrir un service souverain d'inférence sur l'IA de qualité de production. La solution combine le service de déploiement privé de GCore Inference Private avec les infrastructures cloud de confiance d'Orange Business, permettant aux entreprises de déployer des charges de travail en temps réel et conformes à l'échelle à travers l'Europe, en mettant l'accent sur les performances à faible latence, la conformité réglementaire et la simplicité opérationnelle.

Moteur du marché

Prolifération des applications d'IA génératives

Le marché connaît une croissance rapide, propulsée par la prolifération des applications génératrices de l'IA. Au fur et à mesure que les organisations déploient de plus en plus de modèles de grandes langues, des outils de conception génératifs, des assistants virtuels et des plateformes de création de contenu, le besoin de capacités d'inférence rapide, précise et évolutive s'est intensifié.

Ces applications génératives exigent des performances à haut débit pour traiter les ensembles de données vastes et complexes tout en fournissant des sorties en temps réel et contextuellement pertinentes. Pour répondre à ces exigences, les entreprises adoptent un matériel d'inférence avancé, l'optimisation des piles de logiciels et l'utilisation de l'infrastructure native du cloud qui prend en charge la mise à l'échelle dynamique.

Cette augmentation de l'utilisation générative de l'IA dans les secteurs tels que les soins de santé, la finance, l'éducation et le divertissement transforme les flux de travail numériques et accélère la demande de solutions d'inférence à haute performance.

- En avril 2025, Google a présenté Ironwood, son TPU de septième génération, conçu spécifiquement pour l'inférence. Ironwood prend en charge les charges de travail génératrices d'IA à grande échelle avec une puissance de calcul, une mémoire et une efficacité énergétiques améliorées. Il intègre le logiciel Pathways et les fonctionnalités de la bande passante SPARSECORE et ICI améliorée, permettant une inférence de haute performance et évolutive pour les modèles d'IA avancés dans diverses industries.

Défi du marché

Défis d'évolutivité et d'infrastructure dans l'inférence de l'IA

Un défi majeur empêchant les progrès du marché de l'inférence de l'IA est de réaliser l'évolutivité et de gérer la complexité des infrastructures. Comme les organisations adoptent de plus en plus des modèles d'IA pour des décisions en temps réel et à haut volume, le maintien de performances cohérentes dans des environnements distribués devient difficile.

La mise à l'échelle des systèmes d'inférence pour répondre à la demande fluctuante sans trop produir les ressources ou compromettre la latence est une préoccupation persistante. De plus, la complexité du déploiement, de la gestion et de l'optimisation de diverses piles matérielles et logicielles dans des environnements hybrides et multi-clouds ajoute une contrainte opérationnelle.

Pour relever ces défis, les entreprises investissent dans des solutions d'infrastructure dynamique, y compris des architectures sans serveur, des plates-formes d'inférence distribuées et des outils automatisés d'orchestration de ressources.

Ces innovations permettent aux entreprises d'évoluer efficacement les charges de travail d'inférence tout en simplifiant la gestion des infrastructures, soutenant ainsi une adoption plus large de l'IA dans diverses industries.

- En décembre 2024, Amazon a présenté une nouvelle fonctionnalité «Échelle à zéro» pour les points de terminaison d'inférence SageMaker. Cette fonctionnalité permet aux points de terminaison de s'étendre automatiquement à zéro instances pendant l'inactivité, d'optimiser la gestion des ressources et la rentabilité des opérations d'inférence sur l'IA basées sur le cloud.

Tendance

Permettre une intelligence en temps réel avec une inférence du nuage hybride

Le marché est témoin d'une tendance croissante vers des solutions d'inférence sur le cloud hybrides, soutenues par la demande croissante d'évolutivité, de flexibilité et de performance à faible latence.

Alors que les entreprises déploient des modèles d'IA dans diverses géographies et des cas d'utilisation, les architectures hybrides intégrant le cloud public, le cloud privé et l'informatique Edge facilitent la distribution dynamique des charges de travail d'inférence.

- Par exemple, en juin 2025, Akamai a introduit sa plate-forme d'inférence AI intégrée à Spinkube et WebAssembly pour permettre le déploiement du modèle à faible latence au bord. En fonctionnant sur une infrastructure cloud distribuée à l'échelle mondiale, la plate-forme prend en charge les modèles d'IA légers et spécifiques au domaine pour des applications en temps réel, reflétant un passage d'une formation centralisée à l'inférence AI distribuée dans les environnements de bord de nuage hybrides.

Cette approche permet un traitement des données plus proche de la source, d'améliorer les temps de réponse, d'assurer la conformité réglementaire et d'optimiser les coûts en distribuant des charges de travail entre les nœuds centralisés et les nœuds de bord. L'inférence du cloud hybride est de plus en plus vitale pour soutenir les applications d'IA en temps réel et faire progresser l'innovation.

Instantané du rapport sur le marché de l'inférence de l'IA

|

Segmentation |

Détails |

|

Par calcul |

GPU, CPU, FPGA, NPU, autres |

|

Par mémoire |

DDR, HBM |

|

Par déploiement |

Cloud, sur site, bord |

|

Par demande |

AI générative, apprentissage automatique, traitement du langage naturel, vision informatique |

|

Par l'utilisateur final |

Consommateur, fournisseurs de services cloud, entreprises |

|

Par région |

Amérique du Nord: États-Unis, Canada, Mexique |

|

Europe: France, Royaume-Uni, Espagne, Allemagne, Italie, Russie, reste de l'Europe | |

|

Asie-Pacifique: Chine, Japon, Inde, Australie, ASEAN, Corée du Sud, reste de l'Asie-Pacifique | |

|

Moyen-Orient et Afrique: Turquie, U.A.E., Arabie saoudite, Afrique du Sud, reste du Moyen-Orient et de l'Afrique | |

|

Amérique du Sud: Brésil, Argentine, reste de l'Amérique du Sud |

Segmentation du marché

- Par calcul (GPU, CPU, FPGA, NPU et autres): Le segment GPU a gagné 27,61 milliards USD en 2024, principalement en raison de ses capacités de traitement parallèles supérieures, ce qui le rend idéal pour les charges de travail IA à haute performance.

- Par mémoire (DDR et HBM): le segment DDR détenait une part de 61,92% en 2024, alimentée par sa compatibilité généralisée et sa rentabilité pour les tâches générales d'inférence de l'IA.

- Par déploiement (cloud, sur site et bord): le segment cloud devrait atteindre 151,53 milliards USD d'ici 2032, en raison de son évolutivité, de sa flexibilité et de son accès à une infrastructure d'IA robuste.

- Par application (AI génératif,Apprentissage automatique, Traitement du langage naturel et vision par ordinateur): Le segment générateur de l'IA devrait atteindre 136,69 milliards USD d'ici 2032, en raison de l'adoption croissante à travers les applications de création, de codage et de conception de contenu.

- Par l'utilisateur final (consommateur, fournisseurs de services cloud et entreprises): le segment des entreprises devrait atteindre 164,68 milliards USD d'ici 2032, propulsé par l'intégration croissante de l'IA dans les opérations commerciales, l'analyse et les stratégies d'automatisation.

Analyse régionale du marché de l'inférence de l'IA

Sur la base de la région, le marché a été classé en Amérique du Nord, en Europe, en Asie-Pacifique, au Moyen-Orient et en Afrique et en Amérique du Sud.

Le marché de l'inférence de l'IA en Amérique du Nord a représenté une part substantielle de 35,95% en 2024, évaluée à 35,34 milliards USD. Cette domination est renforcée par l'adoption croissante de l'inférence de l'IA de bord entre les secteurs tels que l'automobile, les appareils intelligents et l'automatisation industrielle, où la latence ultra-bas et le traitement localisé deviennent des exigences opérationnelles.

La disponibilité croissante des plates-formes AI-AS-A-Service remodèle également les modèles de déploiement d'IA d'entreprise en offrant une inférence évolutive sans infrastructure dédiée.

- Par exemple, en décembre 2024, Amazon Web Services (AWS) a investi 10 milliards de dollars N Ohio pour étendre son infrastructure cloud et IA. L'investissement vise à établir de nouveaux centres de données pour répondre à la demande croissante, tout en soutenant les progrès technologiques et en renforçant le rôle de l'Ohio dans l'économie numérique.

Ce développement renforce l'écosystème d'inférence de l'IA en élargissant les capacités d'IA basées sur le cloud dans la région. Alors que les entreprises comptent de plus en plus sur des infrastructures cloud robustes pour déployer des modèles d'inférence à grande échelle, ces investissements devraient accélérer l'innovation et l'adoption entre les secteurs, renforçant la position principale d'Amérique du Nord.

L'industrie de l'inférence de l'IA en Asie-Pacifique devrait enregistrer le TCAC le plus rapide de 19,29% au cours de la période de prévision. Cette croissance est principalement attribuée à l'adoption croissante des technologies propulsées par l'IA à travers les principales verticales, notamment la fabrication, les télécommunications et les soins de santé.

La demande croissante de prise de décision en temps réel et à faible latence augmente le déploiement de solutions d'inférence AI END, en particulier dans les écosystèmes de fabrication intelligents et les applications robotiques. En outre, les programmes de numérisation en cours dirigés par le gouvernement et les efforts stratégiques pour renforcer les capacités nationales de l'IA consistent à favoriser un environnement propice pour un déploiement d'évolutivité de l'IA.

- En juin 2025, SK Group et Amazon Web Services ont conclu un partenariat stratégique de 15 ans pour construire un centre de données d'IA à Ulsan, en Corée du Sud. La collaboration vise à établir une nouvelle zone AWS AI avec une infrastructure d'IA dédiée, des réseaux ultraclustes et des services tels qu'Amazon Sagemaker et Amazon Bedrock pour soutenir localement le développement d'applications AI avancées.

Cadres réglementaires

- Aux États-Unis, la Federal Trade Commission (FTC) et la Food and Drug Administration (FDA) réglemententintelligence artificielle, la FTC supervisant son utilisation dans la protection des consommateurs et la FDA régissant sa demande dans les dispositifs médicaux.

Paysage compétitif

Le marché de l'inférence de l'IA se caractérise par des progrès continus dans l'optimisation du moteur et un changement croissant vers l'infrastructure modulaire open source.

Les entreprises privilégient le raffinement des moteurs d'inférence pour permettre des temps de réponse plus rapides, une latence plus faible et une consommation d'énergie réduite. Ces améliorations sont essentielles pour l'échelle des applications d'IA en temps réel dans les environnements cloud, bord et hybrides.

L'industrie assiste à l'adoption croissante de cadres open source et d'architectures de système modulaire qui permettent des déploiements flexibles et indépendants du matériel. Cette approche permet aux développeurs d'intégrer des solutions d'inférence personnalisées adaptées à des charges de travail spécifiques tout en optimisant l'utilisation des ressources et la rentabilité.

Ces progrès permettent une plus grande évolutivité, interopérabilité et efficacité opérationnelle dans la prestation des capacités de l'IA de grade d'entreprise.

- En juin 2025, Oracle et Nvidia ont élargi leur collaboration pour améliorer les capacités de formation et d'inférence de l'IA en mettant NVIDIA AI Enterprise disponible via la console d'Oracle Cloud Infrastructure. Cette intégration permet aux clients d'accéder à plus de 160 outils d'IA, y compris des microservices d'inférence optimisés et de tirer parti des systèmes NVIDIA GB200 NVL72 pour des déploiements d'IA à haute performance, évolutifs et économiques à travers des environnements cloud distribués.

- En mai 2025, Red Hat a introduit le serveur d'inférence RED HAT AI, construit sur le projet VllM open-source et amélioré avec les technologies magiques neurales. La plate-forme est conçue pour offrir une inférence IA à haute performance et rentable dans les environnements cloud hybrides, prenant en charge les modèles d'IA génératifs sur n'importe quel accélérateur.

Les entreprises clés sur le marché de l'inférence de l'IA:

- Openai

- com, Inc.

- Alphabet Inc

- Ibm

- Hugging Face, Inc.

- Bassier

- Ensemble Computer Inc

- Infra profonde

- Modal

- Nvidia Corporation

- Advanced Micro Devices, Inc.

- Intel Corporation

- Cérébras

- Huawei Investment & Holding Co., Ltd.

- D-Matrix, Inc.

Développements récents (partenariats / lancements de produits)

- En mai 2025, OODA AI s'est associé à Phala Network pour explorer l'intégration de l'inférence confidentielle de l'IA à l'aide d'environnements d'exécution de confiance et d'infrastructure GPU décentralisée. La collaboration se concentre sur la création d'un réseau d'inférence AI vérifiable et vérifiable de confidentialité, en tirant parti des preuves zéro-connaissances et des technologies informatiques confidentielles basées sur la blockchain.

- En janvier 2025, Qualcomm Technologies, Inc. a lancé la solution d'appareil AI sur prém et la suite d'inférence AI. Les offres permettent le déploiement sur site des charges de travail génératrices de l'IA et de la vision par ordinateur, permettant aux entreprises de maintenir la confidentialité des données, de réduire les coûts opérationnels et de déployer les applications d'IA localement dans les industries avec le soutien de Honeywell, Atitina et IBM.

- En janvier 2025, Novita AI s'est associée à VLLM pour améliorer les capacités d'inférence de l'IA pour les modèles de grandes langues. La collaboration permet aux développeurs de déployer des LLM open source, tels que Llama 3.1, en utilisant l'algorithme PAGEDATTERAT de VLLM sur l'infrastructure cloud GPU de Novita AI, l'amélioration des performances, la réduction des coûts et la progression du développement de l'IA à source libre.

- En août 2024, Cerebras Systems a lancé l'inférence de Cerebras, une solution d'inférence AI capable de fournir jusqu'à 1 800 jetons par seconde. Propulsé par le moteur 3 à l'échelle de plaquette, la solution offre des coûts considérablement inférieurs et des performances plus élevées que les alternatives basées sur GPU, avec des niveaux de prix gratuits, développeurs et d'entreprise.

Questions fréquemment posées