Jetzt anfragen

KI -Inferenzmarkt

KI-Inferenzmarktgröße, Anteil, Wachstum und Branchenanalyse nach Compute (GPU, CPU, FPGA, NPU, Andere), nach Speicher (DDR, HBM), nach Bereitstellung (Cloud, On-Premise, Edge), nach Anwendung, nach Endbenutzer und regional 2025-2032

Seiten: 200 | Basisjahr: 2024 | Veröffentlichung: July 2025 | Autor: Versha V.

KI -Inferenzmarkt Snapshot

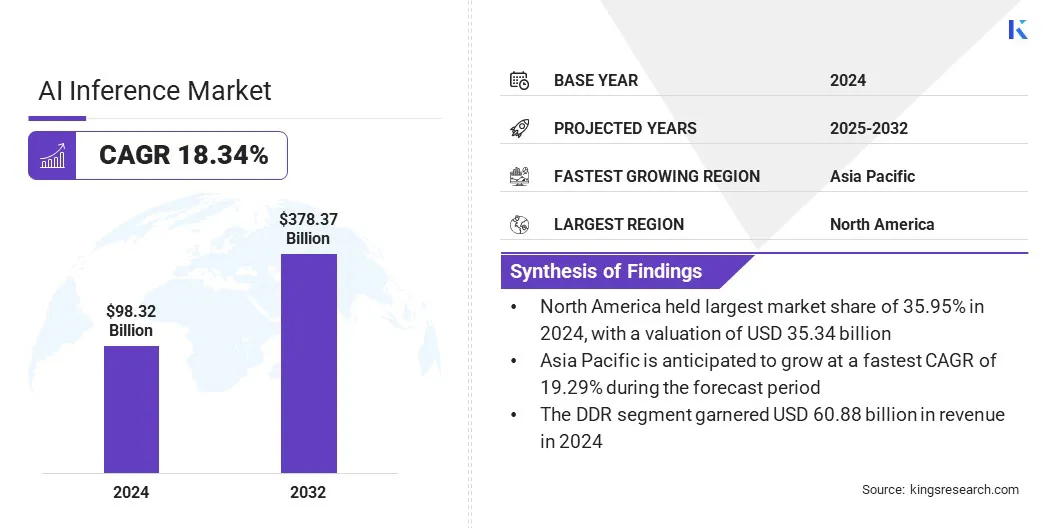

Die globale KI -Inferenzmarktgröße wurde im Jahr 2024 mit 98,32 Milliarden USD geschätzt und wird voraussichtlich im Voraussagen von 116,30 Milliarden USD im Jahr 2025 auf 378,37 Mrd. USD wachsen, was im Prognosezeitraum einen CAGR von 18,34% aufwies. Der Markt verzeichnet ein robustes Wachstum, das hauptsächlich durch die rasche Verbreitung generativer KI -Anwendungen in verschiedenen Branchen angetrieben wird.

Da Unternehmen zunehmend KI-Modelle für Aufgaben wie Inhaltsgenerierung, Echtzeitübersetzung und personalisierte Empfehlungen einsetzen, ist die Nachfrage nach effizienten Lösungen für leistungsstarke Inferenzlösungen gestiegen.

Wichtige Markthighlights:

- Die weltweite Marktgröße wurde im Jahr 2024 bei 98,32 Milliarden USD bewertet.

- Der Markt wird voraussichtlich von 2025 bis 2032 mit einem CAGR von 18,34% wachsen.

- Nordamerika hatte im Jahr 2024 einen Anteil von 35,95% im Wert von 35,34 Milliarden USD.

- Das GPU -Segment erzielte 2024 einen Umsatz von 27,61 Milliarden USD.

- Das DDR -Segment wird voraussichtlich bis 2032 USD 228,57 Milliarden in Höhe von USD erreichen.

- Das Cloud -Segment wird voraussichtlich bis 2032 einen Umsatz von 151,53 Milliarden USD generieren.

- Das generative KI -Segment wird voraussichtlich bis 2032 USD 136,69 Mrd. USD erreichen.

- Das Unternehmenssegment erreicht bis 2032 auf 164,68 Milliarden USD.

- Der asiatisch -pazifische Raum wird voraussichtlich im Prognosezeitraum auf einer robusten CAGR von 19,29% wachsen.

Große Unternehmen, die in der KI-Inferenzbranche tätig sind, sind Openai, Amazon.com, Inc., Alphabet Inc., IBM, Hugging Face, Inc., Baseten, zusammen Computer Inc., Deep Infra, Modal, NVIDIA Corporation, Advanced Micro Devices, Inc., Intel Corporation, Cerebras, Huawei Investment & Hold & Hold & Hold & Hold & Hold & Hold & Hold & Hold & Hold & Hold & Hold & Hold & Hold & Hold & Hold & Hold & Hold & Hold & Hold & Hold & Hold & Hold & Hold & Hold & Hold & Hold & Hold & Hold & Hold & Hold & Hold & Hold & Hold, Ltd.

KI -Inferenzmarktübersicht

Die zunehmende Betonung der Datensouveränität und der Einhaltung der Regulierung beeinflusst die Unternehmensnachfrage nach KI -Inferenzlösungen. Organisationen bevorzugen zunehmend Inferenzdienste, die eine Echtzeitleistung mit vollständiger Kontrolle über Daten und Infrastruktur bieten.

- Im Juni 2025 starteten Gcore und Orange Business ein strategisches Co-Innovationsprogramm, um einen souveränen, produktionsgradigen KI-Inferenzdienst zu bieten. Die Lösung kombiniert GCORes KI-Inferenz privater Bereitstellungsdienst mit der vertrauenswürdigen Cloud-Infrastruktur von Orange Business, mit der Unternehmen in ganz Europa Echtzeit, konforme Inferenz-Workloads in Maßstab bereitstellen können, wobei der Schwerpunkt auf der Leistung mit geringer Latenz, regulatorischer Konformität und Betriebseinfachheit liegt.

Marktfahrer

Verbreitung generativer KI -Anwendungen

Der Markt verzeichnet ein schnelles Wachstum, das durch die Verbreitung generativer KI -Anwendungen angetrieben wird. Da Organisationen großer Sprachmodelle, generative Design -Tools, virtuelle Assistenten und Inhaltserstellungsplattformen, zunehmend einsetzen, hat sich die Notwendigkeit einer schnellen, genauen und skalierbaren Inferenzfunktionen verstärkt.

Diese generativen Anwendungen erfordern eine hohe Durchsatzleistung, um riesige und komplexe Datensätze zu verarbeiten und gleichzeitig in Echtzeit, kontextbezogene Ausgaben zu liefern. Um diese Anforderungen zu erfüllen, übernehmen Unternehmen erweiterte Inferenzhardware, optimieren Software-Stapel und nutzen die Cloud-native Infrastruktur, die dynamische Skalierung unterstützt.

Dieser Anstieg der generativen KI-Nutzung in Bereichen wie Gesundheitswesen, Finanzen, Bildung und Unterhaltung verändert digitale Workflows und beschleunigt die Nachfrage nach leistungsstarken Inferenzlösungen.

- Im April 2025 stellte Google Ironwood, seine TPU der siebten Generation, vor, die speziell für Inferenz entwickelt wurde. Ironwood unterstützt groß angelegte generative KI-Workloads mit verbesserter Rechenleistung, Speicher und Energieeffizienz. Es integriert die Pathways-Software von Google und verfügt über eine verbesserte Sparsecore- und ICI-Bandbreite, wodurch Hochleistungs- und skalierbare Inferenz für fortschrittliche KI-Modelle in verschiedenen Branchen ermöglicht werden.

Marktherausforderung

Skalierbarkeit und Infrastrukturherausforderungen in der KI -Inferenz

Eine große Herausforderung, die den Fortschritt des KI -Inferenzmarktes behindert, besteht darin, die Skalierbarkeit und die Verwaltung der Komplexität der Infrastruktur zu erreichen. Da Organisationen zunehmend KI-Modelle für die Entscheidungsfindung in Echtzeit, hochvolumiger Entscheidung einsetzen, wird die Aufrechterhaltung einer konsistenten Leistung in überverteilter Umgebungen schwierig.

Die Skalierung von Inferenzsystemen, um die schwankende Nachfrage zu befriedigen, ohne Ressourcen zu überlegen oder die Latenz zu beeinträchtigen, ist ein anhaltendes Problem. Darüber hinaus fügt die Komplexität des Bereitstellens, Verwaltens und Optimierens verschiedener Hardware- und Software-Stapel in hybriden und multi-cloud-Umgebungen eine operative Belastung hinzu.

Um diese Herausforderungen zu bewältigen, investieren Unternehmen in dynamische Infrastrukturlösungen, einschließlich serverloser Architekturen, verteilter Inferenzplattformen und automatisierter Ressourcenorchestrierungstools.

Diese Innovationen ermöglichen es Unternehmen, die Workloads in Bezug auf die Inferenz effizient zu skalieren und gleichzeitig das Management des Infrastruktur zu vereinfachen und so eine breitere KI -Einführung in verschiedenen Branchen zu unterstützen.

- Im Dezember 2024 führte Amazon für Sagemaker -Inferenzendpunkte eine neue Funktion „Skala to Zero“ ein. Mit dieser Funktion können Endpunkte während der Inaktivität automatisch auf null Instanzen skalieren und das Ressourcenmanagement und die Kosteneffizienz für Cloud-basierte KI-Inferenzvorgänge optimieren.

Markttrend

Ermöglichen Sie Echtzeit-Intelligenz mit Hybrid-Cloud-Inferenz

Der Markt verzeichnet einen wachsenden Trend zu hybriden Cloud-basierten Inferenzlösungen, die durch die steigende Nachfrage nach Skalierbarkeit, Flexibilität und Leistung mit geringer Latenz unterstützt werden.

Da Unternehmen KI -Modelle in verschiedenen Regionen und Anwendungsfällen einsetzen, erleichtern hybride Architekturen, die öffentliche Cloud, Private Cloud und Edge Computing integrieren, die dynamische Verteilung von Inferenz -Arbeitsbelastungen.

- Zum Beispiel führte Akamai im Juni 2025 seine KI-Inferenzplattform ein, die in Spinkube und WebAssembly integriert war, um die Bereitstellung von Modellmodellen mit niedrigem Latenz am Rande zu ermöglichen. Die Plattform wird auf einer global verteilten Cloud-Infrastruktur ausgeführt und unterstützt leichte, domänenspezifische KI-Modelle für Echtzeitanwendungen, was eine Verschiebung von zentralem Training zu verteilten KI-Inferenz in hybriden Cloud-Kanten-Umgebungen widerspiegelt.

Dieser Ansatz ermöglicht die Datenverarbeitung näher an der Quelle, die Verbesserung der Reaktionszeiten, die Gewährleistung der regulatorischen Einhaltung und die Optimierung der Kosten, indem die Workloads zwischen zentralisierten und Kantenknoten verteilt werden. Hybrid-Cloud-Inferenz ist immer wichtiger für die Unterstützung von AI-Anwendungen in Echtzeit und die Förderung der Innovation.

KI -Inferenzmarktbericht Snapshot

|

Segmentierung |

Details |

|

Durch Berechnung |

GPU, CPU, FPGA, NPU, andere |

|

Durch Gedächtnis |

DDR, HBM |

|

Durch Bereitstellung |

Wolke, On-Premise, Edge |

|

Durch Anwendung |

Generative KI, maschinelles Lernen, Verarbeitung natürlicher Sprache, Computer Vision |

|

Nach Endbenutzer |

Verbraucher, Cloud -Dienstleister, Unternehmen |

|

Nach Region |

Nordamerika: USA, Kanada, Mexiko |

|

Europa: Frankreich, Großbritannien, Spanien, Deutschland, Italien, Russland, Rest Europas | |

|

Asiatisch-pazifik: China, Japan, Indien, Australien, ASEAN, Südkorea, Rest des asiatisch-pazifischen Raums | |

|

Naher Osten und Afrika: Türkei, U.A.E., Saudi -Arabien, Südafrika, Rest von Naher Osten und Afrika | |

|

Südamerika: Brasilien, Argentinien, Rest Südamerikas |

Marktsegmentierung

- Durch Berechnung (GPU, CPU, FPGA, NPU und andere): Das GPU-Segment verdiente sich im Jahr 2024 USD 27,61 Milliarden USD, hauptsächlich aufgrund der überlegenen Parallelverarbeitungsfunktionen, was es ideal für leistungsstarke KI-Arbeitsbelastungen macht.

- Nach Speicher (DDR und HBM): Das DDR-Segment hielt 2024 einen Anteil von 61,92%, was durch seine weit verbreitete Kompatibilität und Kosteneffizienz für allgemeine KI-Inferenzaufgaben angetrieben wurde.

- Durch Bereitstellung (Cloud, On-Premise und Edge): Das Cloud-Segment wird aufgrund seiner Skalierbarkeit, Flexibilität und Zugang zu robuster KI-Infrastruktur bis 2032 voraussichtlich bis 2032 USD $ 151,53 Milliarden erreichen.

- Durch Anwendung (generative KI,Maschinelles Lernen, Natürliche Sprachverarbeitung und Computer Vision): Das generative KI -Segment wird voraussichtlich bis 2032 in Höhe von 136,69 Milliarden USD erreicht, da die Einführung von Inhalts-, Codierung und Designanwendungen steigend eingeht.

- Nach dem Endbenutzer (Verbraucher, Cloud -Service -Anbieter und Unternehmen): Das Unternehmenssegment wird voraussichtlich bis 2032 in Höhe von 164,68 Milliarden USD erreichen, die durch die wachsende Integration von KI in Geschäftsabläufe, Analysen und Automatisierungsstrategien angetrieben werden.

KI -Inferenzmarkt regionale Analyse

Basierend auf der Region wurde der Markt in Nordamerika, Europa, Asien -Pazifik, Naher Osten und Afrika und Südamerika eingeteilt.

Der Markt für KI -Inferenz in Nordamerika machte 2024 einen erheblichen Anteil von 35,95% im Wert von 35,34 Milliarden USD aus. Diese Dominanz wird durch die steigende Einführung von Edge-AI-Inferenz über Sektoren wie Automobile, intelligente Geräte und industrielle Automatisierung hinweg verstärkt.

Die wachsende Verfügbarkeit von AI-AS-A-Service-Plattformen ist auch die Umgestaltung von Enterprise-AI-Bereitstellungsmodellen, indem skalierbare Folgerungen ohne dedizierte Infrastruktur angeboten werden.

- Zum Beispiel investierte Amazon Web Services (AWS) im Dezember 2024 10 Milliarden USD N Ohio, um seine Cloud- und KI -Infrastruktur zu erweitern. Die Investition zielt darauf ab, neue Rechenzentren zu schaffen, um die steigende Nachfrage zu befriedigen, und gleichzeitig den technologischen Fortschritt und die Stärkung der Rolle von Ohio in der digitalen Wirtschaft zu unterstützen.

Diese Entwicklung stärkt das KI-Inferenzökosystem, indem sie die KI-Funktionen in Cloud-basierten KI in der Region erweitern. Da sich Unternehmen zunehmend auf eine robuste Cloud -Infrastruktur verlassen, um Inferenzmodelle im Maßstab einzusetzen, wird erwartet, dass diese Investitionen die Innovation und die Einführung in den Sektoren beschleunigen, was die führende Position Nordamerikas verstärkt.

Die Asien-Pazifik-KI-Inferenzbranche wird voraussichtlich im Prognosezeitraum die schnellste CAGR von 19,29% registrieren. Dieses Wachstum wird in erster Linie auf die steigende Einführung von KI-betriebenen Technologien über wichtige Vertikale hinweg zurückgeführt, einschließlich Fertigung, Telekommunikation und Gesundheitsversorgung.

Die zunehmende Nachfrage nach Echtzeit-Entscheidungen mit geringer Latenz steigert den Einsatz von Edge-AI-Inferenzlösungen, insbesondere innerhalb der intelligenten Fertigung Ökosysteme und Robotikanwendungen. Darüber hinaus fördern die laufenden staatlich geführten Digitalisierungsprogramme und die strategischen Bemühungen zur Stärkung der inländischen KI-Fähigkeiten ein förderliches Umfeld für skalierbare KI-Einsätze.

- Im Juni 2025 haben die SK Group und Amazon Web Services eine 15-jährige strategische Partnerschaft eingetragen, um ein AI-Rechenzentrum in Ulsan, Südkorea, aufzubauen. Die Zusammenarbeit zielt darauf ab, eine neue AWS -AI -Zone mit dedizierter KI -Infrastruktur, ultracluster -Netzwerken und Diensten wie Amazon Sagemaker und Amazon Bedrock aufzunehmen, um die Entwicklung fortschrittlicher AI -Anwendungen vor Ort zu unterstützen.

Regulatorische Rahmenbedingungen

- In den USA, Die Federal Trade Commission (FTC) und die Food and Drug Administration (FDA) regulierenkünstliche IntelligenzMit der FTC überwacht die Verwendung im Verbraucherschutz und die FDA, die ihre Anwendung in medizinischen Geräten regiert.

Wettbewerbslandschaft

Der KI-Inferenzmarkt ist durch kontinuierliche Fortschritte bei der Motoroptimierung und eine wachsende Verschiebung in Richtung Open-Source-modularer Infrastruktur gekennzeichnet.

Unternehmen priorisieren die Verfeinerung von Inferenzmotoren, um schnellere Reaktionszeiten, geringere Latenz und reduzierte Energieverbrauch zu ermöglichen. Diese Verbesserungen sind entscheidend für die Skalierung von AI-Anwendungen in Echtzeit in Cloud-, Edge- und Hybridumgebungen.

Die Branche verzeichnet eine steigende Einführung von Open-Source-Frameworks und modularen Systemarchitekturen, die flexible, hardware-agnostische Bereitstellungen ermöglichen. Dieser Ansatz ermöglicht es Entwicklern, maßgeschneiderte Inferenzlösungen zu integrieren, die auf bestimmte Workloads zugeschnitten sind und gleichzeitig die Ressourcenauslastung und die Kosteneffizienz optimieren.

Diese Fortschritte ermöglichen eine größere Skalierbarkeit, Interoperabilität und operative Effizienz bei der Bereitstellung von Unternehmensfunktionen der Unternehmensklasse.

- Im Juni 2025 erweiterten Oracle und Nvidia ihre Zusammenarbeit, um die KI -Schulungs- und Inferenzfunktionen zu verbessern, indem Nvidia AI Enterprise über die Oracle Cloud -Infrastrukturkonsole nativ verfügbar gemacht wurde. Mit dieser Integration können Kunden über 160 KI-Tools zugreifen, darunter optimierte Inferenzmikrodienste, und die NVIDIA GB200 NVL72-Systeme für leistungsstarke, skalierbare und kosteneffiziente AI-Bereitstellungen über verteilte Cloud-Umgebungen in Bezug auf leistungsstarke, skalierbare und kosteneffiziente AI-Bereitstellungen nutzen.

- Im Mai 2025 führte Red Hat den Red Hat AI Inference Server ein, der auf dem Open-Source-VLLM-Projekt basiert und mit neuronalen Magic-Technologien verbessert wurde. Die Plattform ist so konzipiert, dass sie leistungsstarke und kosteneffiziente KI-Inferenz in hybriden Cloud-Umgebungen liefert und generative KI-Modelle für jeden Beschleuniger unterstützt.

Schlüsselunternehmen im KI -Inferenzmarkt:

- Openai

- Com, Inc.

- Alphabet Inc.

- IBM

- Umarmung Face, Inc.

- Basis

- Zusammen Computer Inc.

- Tiefe Infrara

- Modal

- Nvidia Corporation

- Advanced Micro Devices, Inc.

- Intel Corporation

- Cerebras

- Huawei Investment & Holding Co., Ltd.

- D-Matrix, Inc.

Jüngste Entwicklungen (Partnerschaften/Produkteinführungen)

- Im Mai 2025, Ooda AI hat sich mit Phala Network zusammengetan, um die Integration vertraulicher KI -Inferenz unter Verwendung vertrauenswürdiger Ausführungsumgebungen und dezentraler GPU -Infrastruktur zu untersuchen. Die Zusammenarbeit konzentriert sich auf den Aufbau eines Datenschutznetzes für die Erziehung, ein überprüfbares KI-Inferenznetz, das Nutzung von Null-Knowledge-Proofs und Blockchain-basierten vertraulichen Computertechnologien nutzt.

- Im Januar 2025, Qualcomm Technologies, Inc. startete die AI On-Prem Apprem-Lösung und die AI Inference Suite. Die Angebote ermöglichen eine lokale Bereitstellung generativer KI- und Computer-Vision-Workloads, sodass Unternehmen die Datenschutzdatenschutz aufrechterhalten, die Betriebskosten senken und AI-Anwendungen lokal in der Branche mit Unterstützung von Honeywell, Aetina und IBM einsetzen können.

- Im Januar 2025, Novita AI hat sich mit VLLM zusammengetan, um die KI -Inferenzfähigkeiten für Großsprachmodelle zu verbessern. Die Zusammenarbeit ermöglicht es Entwicklern, Open-Source-LLMs wie LLAMA 3.1 bereitzustellen, wobei der PAGEDATTENTION-ALGORITHM von VLLM auf der GPU-Cloud-Infrastruktur der Novita AI von Novita AI, Verbesserung der Leistung, der Reduzierung der Kosten und der Förderung der Open-Source-AI-Entwicklung.

- Im August 2024, Cerebras -Systeme haben Cerebras -Inferenz eingeführt, eine KI -Inferenzlösung, die bis zu 1.800 Token pro Sekunde liefern kann. Die Lösung wird von der Wafer Scale Engine 3 angetrieben und bietet erheblich niedrigere Kosten und höhere Leistung als GPU-basierte Alternativen, wobei kostenlose, Entwickler- und Unternehmenspreise.

Häufig gestellte Fragen